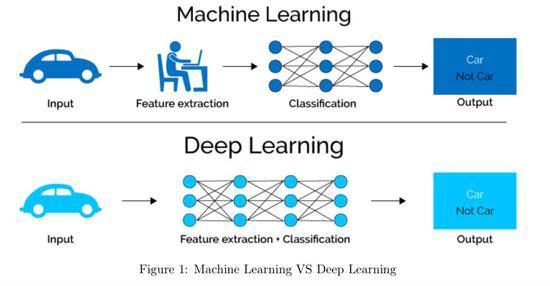

Dropout是一种常用的正则化技术,用于减少机器学习模型的过拟合。在训练过程中,通过随机“丢弃”网络中的一些神经元,dropout帮助模型学习更鲁棒的特征表示。它在深度学习中特别有效,尤其是在处理端到端的复杂任务时。

在机器学习与深度学习领域,dropout技术是一项重要的防止过拟合的策略,它通过在训练阶段随机“丢弃”一些神经元,来减少模型对特定数据的依赖,进而提升模型在新数据上的泛化能力,本文将深入探讨dropout的工作机制、应用场景及其在实际编程框架中的应用方法。

Dropout的工作原理

Dropout操作可以类比于在每次训练迭代中从原始网络中随机抽取一个子网络来训练,对于某一层神经网络,在每一个训练批次中,会随机选择一部分神经元暂时从网络中移除,这意味着这些被选中的神经元在该次迭代中既不参与前向传播,也不参与反向传播,每次迭代实际上都在训练一个更简单的网络,但由于这种随机性,每一个批次的数据都会训练不同的网络结构。

Dropout的应用

1、减少过拟合:过拟合是模型在训练数据上表现优秀,但在未见的新数据上性能下降的现象,通过引入dropout,可以减少模型对单一训练样本特性的依赖,从而提高模型的泛化能力。

2、增强模型的鲁棒性:由于dropout的随机性质,模型不会过度依赖任何一个神经元或连接,这增强了模型对噪声和异常值的处理能力。

3、提供模型集成效果:每个训练批次由于dropout的作用,都在训练不同的网络子集,这种随机性相当于在训练过程中对多个子模型进行了集成,有助于提升模型的整体性能。

手动实现及框架支持

手动实现dropout并不复杂,可以通过编程设置每个神经元有一个固定概率p被随机清零(即不参与当前训练批次),在测试阶段,需要将层中每个神经元的输出乘以p,以模拟整个网络结构仍然完整的情况。

在现代深度学习框架如PyTorch中,实现dropout变得极为简单,在PyTorch中,可以通过简单地调用torch.nn.Dropout(p)来实现dropout操作,其中p是丢弃神经元的概率,这样,每当输入数据通过网络时,对应的神经元就会按照指定的概率p被随机清零。

相关FAQs

问:为什么dropout能够减少过拟合?

答:Dropout通过随机禁用网络中的一些神经元,减少了模型在训练数据上过分优化的风险,这种做法使得模型不可能完全依赖于任何一个特定的神经元或数据样本,从而必须学习更加普遍和鲁棒的特征,最终达到降低过拟合的效果。

问:如何在现有的深度学习模型中应用dropout?

答:在大多数深度学习框架中,添加dropout只需在模型定义中相应层后添加Dropout层即可,在PyTorch中,可以在全连接层后添加nn.Dropout(p),其中p是你想要设置的丢弃率,这样,在每次训练迭代中,该层的输出会有p比例的神经元被随机设置为0,实现dropout效果。

dropout作为一种有效的正则化技术,在提高模型泛化能力、减少过拟合方面发挥着重要作用,通过随机地“丢弃”网络中的神经元,模型被强迫去学习数据中更加普遍的模式,而不是过分依赖于训练数据中的特定样本,其在深度学习框架中的易用性使得dropout成为了深度学习实践中不可或缺的一部分。

本文来源于互联网,如若侵权,请联系管理员删除,本文链接:https://www.9969.net/14256.html