本文主要介绍了如何配置Kafka/DMS Kafka源端参数。内容包括了Kafka的基本概念,以及如何进行参数配置,包括设置主题、分区数、副本数等关键参数,以优化Kafka的性能和稳定性。

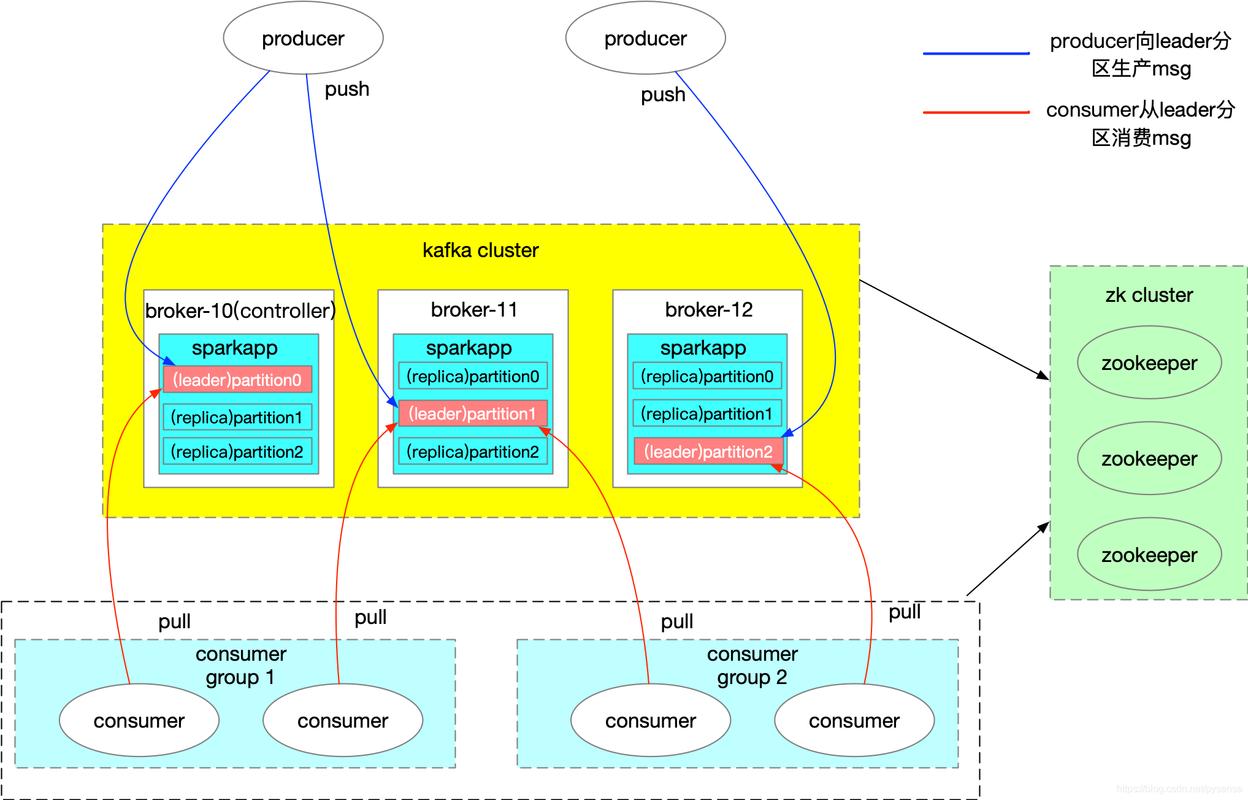

Kafka是一个分布式流处理平台,用于构建实时数据管道和流应用程序,DMS(Data Management Service)是阿里云提供的一种数据管理服务,可以用于数据的迁移、同步等操作。

以下是配置Kafka/DMS Kafka源端参数的详细步骤:

1、创建Kafka集群

登录阿里云控制台,进入DMS控制台。

在左侧导航栏中,选择“Kafka集群”。

点击“新建Kafka集群”,填写集群名称、地域、可用区等信息。

设置Kafka版本、实例规格、副本数量等参数。

点击“确认”按钮,等待集群创建完成。

2、配置Kafka源端参数

在DMS控制台中,选择“Kafka集群”。

找到刚刚创建的Kafka集群,点击“配置”。

在配置页面中,可以设置以下参数:

Topic:创建一个新的Topic或者选择一个已有的Topic作为数据源。

Partition:设置Topic的分区数量。

Replication Factor:设置Topic的副本数量,以提高数据的可靠性。

Producer:设置生产者的配置参数,如消息大小限制、压缩类型等。

Consumer Group:设置消费者组的配置参数,如自动提交偏移量的时间间隔、会话超时时间等。

Access Control List (ACL):设置访问控制列表,以限制哪些用户或客户端可以访问Kafka集群。

Security Settings:设置安全相关的参数,如SSL/TLS加密、SASL认证等。

修改完成后,点击“保存”按钮。

3、创建Kafka源端连接

在DMS控制台中,选择“数据迁移任务”。

点击“新建数据迁移任务”,填写任务名称、源端类型(Kafka)、目标端类型等信息。

在源端配置部分,选择刚刚创建的Kafka集群,并填写相关参数,如Topic、分区等。

在目标端配置部分,选择目标数据库或存储系统,并填写相关参数。

设置数据迁移的过滤条件、转换规则等。

点击“确认”按钮,等待任务创建完成。

4、启动数据迁移任务

在DMS控制台中,选择“数据迁移任务”。

找到刚刚创建的任务,点击“启动”按钮。

在弹出的对话框中,确认源端和目标端的参数无误后,点击“确定”按钮。

任务将开始执行数据迁移过程。

就是配置Kafka/DMS Kafka源端参数的详细步骤,根据实际需求,还可以对其他参数进行调整和优化。

本文来源于互联网,如若侵权,请联系管理员删除,本文链接:https://www.9969.net/14538.html