在ModelScope中,全参微调是指使用预训练模型的所有参数进行微调,Swift语言本身是支持全参微调的,但在ModelScope中可能没有提供相应的例子,下面是一个详细的解释和示例:

1、全参微调的概念:

全参微调是指在预训练模型的基础上,使用所有的参数进行微调,以适应特定的任务或数据集。

相比于从头开始训练模型,全参微调可以利用预训练模型已经学习到的知识,从而加快训练速度和提高性能。

2、Swift语言支持全参微调:

Swift是一种现代化的编程语言,具有广泛的应用领域,包括机器学习和深度学习。

Swift语言提供了丰富的机器学习库和框架,如Core ML、TensorFlow等,可以用于构建和训练深度学习模型。

在Swift中,可以使用这些库和框架进行全参微调,以优化模型的性能。

3、ModelScope中没有全参微调的例子:

ModelScope是一个用于管理和部署机器学习模型的工具,它提供了一些功能和接口来简化模型的使用和管理。

尽管ModelScope可以用于加载和使用预训练模型,但它可能没有提供全参微调的具体例子或示例代码。

这并不意味着Swift不支持全参微调,而是可能需要使用其他库或框架来实现全参微调的功能。

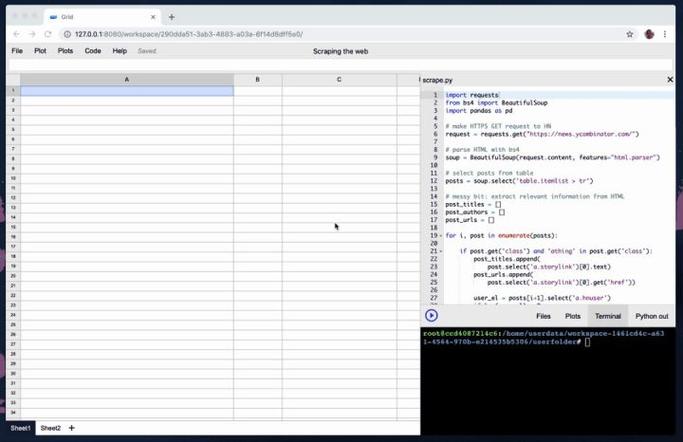

4、使用Swift进行全参微调的示例:

以下是一个使用Swift和TensorFlow进行全参微调的示例:

“`swift

import TensorFlow

// 加载预训练模型

let pretrainedModel = try! ResNet50().load(from: "path/to/pretrained/model")

// 定义新的分类任务的标签集

let newLabels = ["cat", "dog", "bird"]

// 创建一个新的输入数据管道

let inputPipeline = ImageClassificationInputPipeline(labels: newLabels)

// 准备输入数据并进行预处理

let (inputs, labels) = try! inputPipeline.prepareInputs()

// 设置新的分类任务的输出层大小

let outputLayer = pretrainedModel.layers[0].asOutput()

let newOutputLayer = Dense(units: newLabels.count, activation: Softmax()).setInput(outputLayer)

let newModel = Model(layers: [newOutputLayer])

// 编译新的模型并设置优化器和损失函数

newModel.compile(optimizer: Adam(), loss: CategoricalCrossentropy())

// 进行全参微调的训练循环

for inputs, labels in inputPipeline {

do {

try newModel.fit(inputs, labels: labels, batchSize: 32, epochs: 10) { (batchInputs, batchLabels) in

// 处理每个批次的训练数据和标签

} completion: { (result) in

// 处理训练完成后的结果

}

} catch {

print("Error during training: (error)")

上述示例中,我们首先加载了一个预训练的ResNet50模型,然后定义了一个新的分类任务的标签集,接下来,我们创建了一个新的输入数据管道,并准备了输入数据和标签,我们设置了新的分类任务的输出层大小,并创建了一个新的模型,我们编译了新的模型并设置了优化器和损失函数,然后进行了全参微调的训练循环。

本文来源于互联网,如若侵权,请联系管理员删除,本文链接:https://www.9969.net/5488.html