要在Spark Python脚本中引用另一个Python脚本,可以通过以下步骤实现:

1、在Spark Python脚本中导入外部Python脚本:

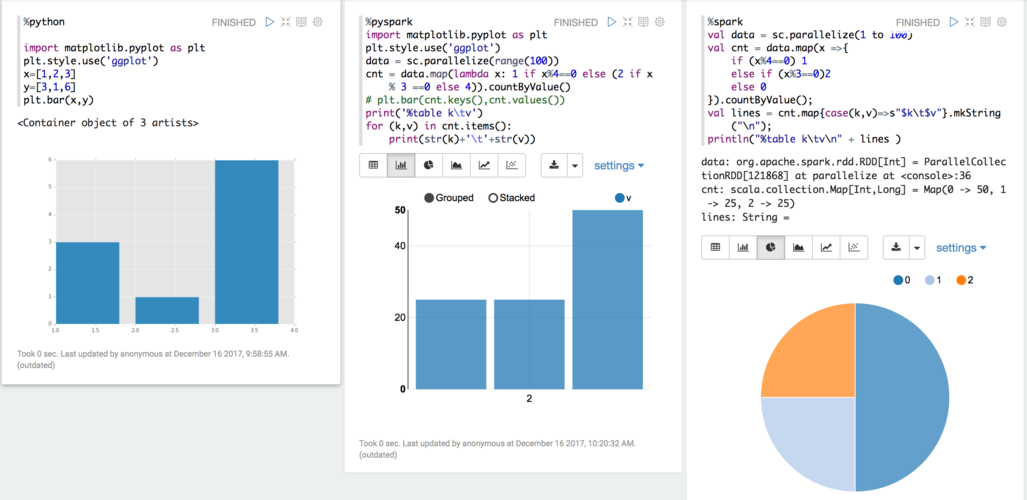

(图片来源网络,侵删)

首先确保你要引用的Python脚本(例如hello.py)已经存在并包含你需要的函数或类。

在Spark Python脚本中使用import 语句来引用这个外部脚本,如果hello.py 中有一个名为hello1 的函数,可以在Spark脚本中这样引用:

```python

import hello

```

(图片来源网络,侵删)

2、调用外部脚本中的函数:

在Spark Python脚本中,可以直接使用外部脚本中定义的函数或类,调用hello1 函数可以如下进行:

```python

hello.hello1(odps)

```

(图片来源网络,侵删)

3、配置运行参数:

在提交Spark作业时,需要通过配置参数来指定外部脚本的位置,这可以通过--py-files 参数来实现,如果hello.py 位于HDFS路径hdfs:///tmp/pyspark/hello.py,那么在提交作业时可以这样配置:

```bash

spark-submit --master yarn --deploy-mode cluster --py-files hdfs:///tmp/pyspark/hello.py your_script.py

```

以下是一个完整的示例:

Spark Python脚本示例(your_script.py)

from pyspark.sql import SparkSession

import hello

def main():

spark = SparkSession.builder

.appName("MyApp")

.getOrCreate()

# 调用外部脚本中的函数

hello.hello1(spark)

if __name__ == "__main__":

main() 外部Python脚本示例(hello.py)

def hello1(spark):

sql_str = """SELECT * FROM my_table"""

df = spark.sql(sql_str)

df.show() 提交作业命令

spark-submit --master yarn --deploy-mode cluster --py-files hdfs:///tmp/pyspark/hello.py your_script.py

通过上述步骤,你可以在Spark Python脚本中成功引用并使用外部Python脚本的功能。

本文来源于互联网,如若侵权,请联系管理员删除,本文链接:https://www.9969.net/59188.html